为什么苹果认为自己是 AI 的领导者?(下)

相关阅读:为什么苹果认为自己是 AI 的领导者?(上)

划重点

苹果的AI战略——从app到框架乃至于芯片的垂直整合对智能体验至关重要

苹果的机器学习应用——在苹果的产品里面几乎很难找到没使用机器学习的地方

为什么要做设备侧做AI——性能和隐私,鱼与熊掌可以兼得

苹果芯的Mac——也许Mac也能具备Neural Engine了

隐私保护——数据在本地处理就是最大的保护

黑箱内部——苹果对AI的曝光度增加了

为什么要在设备侧进行机器学习?

在交谈中,Giannandrea和Borchers均强调,之前看过的功能之所以有实现的可能,是因为所有工作都是在设备本地完成的。

有一种常见的说法是,机器学习可以归结为这个:更多数据意味着更好的模型,这反过来又意味着可提供更好的用户体验和产品。这就是观察者往往认为Google、Amazon或者Facebook也许是AI统治者的原因之一。这些公司管理着庞大的数据收集引擎,部分是因为是它们运营着在全球范围内已经成为重要的数字基础设施的东西,而且对里面的东西具有完全的可见性。按照这种观点来看的话,有些人会认为苹果的表现差强人意,因为苹果的商业模式不同,而且公开承诺要对数据收集进行限制。

我把这个观点向Giannandrea提出来时,他并没有避而不谈:

是,这种位于数据中心的更大规模的模型多少要准确些的看法我可以理解,但那实际上是错误的。其实从技术上讲也是错误的。最好是在靠近数据的地方去跑模型,而不是到处去移动数据。不管是位置数据(比方说你在做什么)还是运动数据(比方说手机里面的的加速计在做什么),最好离数据源很近,这样也可以保护隐私。

Borchers和Giannandrea均反复指出,在数据中心进行这项工作对隐私是有影响的,但是Giannandrea说在本地处理也与性能有关。

他说:“还有一点很重要,那就是延迟。如果你要向数据中心传输内容,想要以以帧速率来做这件事其实是非常困难的。所以,我们在应用商店里面有很多app在做这样一些事情,比方说姿势估计,比方说弄清楚人的走动情况,以及比方说确定他们胳膊大腿在哪里。这些都我们提供的高级API。基本上,只有在你可以用帧速率完成这些人物时才有用。”

他还提供了另一个消费者用例的例子:

假设你正在拍照,其实你在使用摄像头拍照之前的时候,摄像头就可以实时看到一切。它可以帮助你确定在什么时候拍摄照片。如果这个决定要由服务器端做出的话,那就得把每一帧都传给服务器,才能决定怎么拍照片。这就没有任何意义了,对吧?所以说,有很多体验是你希望在边缘设备侧完成的。

当被问及苹果是怎么选择在什么时候在设备侧做某件事情时,Giannandrea的回答很简单:“只要在设备侧做的质量达到或超过在服务器侧做,我们就选择在设备侧去做。”

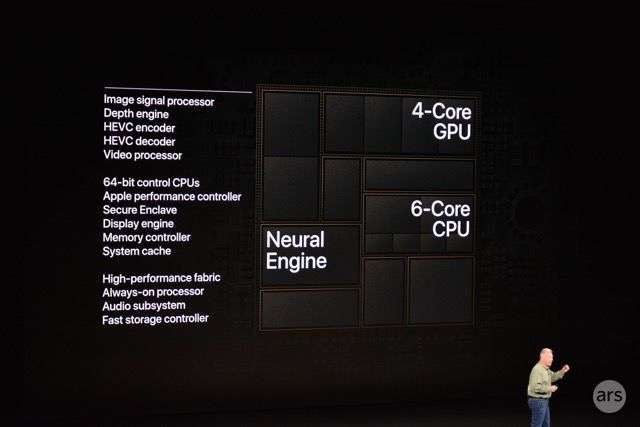

此外,两位苹果高管都认为苹果的定制芯片(尤其是自iPhone 8和iPhone X以来iPhone内置的包含的ANE芯片)是设备侧处理的前提条件。Neural Engine是苹果设计的八核神经网络处理单元(NPU),用于处理某些类型的机器学习任务。

Giannandrea说:“整个过程经历了好几年的时间,因为五年前在边缘层还没有硬件可以做到这一点。ANE的设计是完全可扩展的。iPad的ANE比手机的ANE要大,后者又要比Apple Watch里面的ANE要大,但是我们所有产品线的app以及开发者的app基本上都是采用同样的的CoreML API层。”

苹果公开谈论Neural Engine的时候,该公司曾分享过它的性能数据,比方说2018年的A12芯片支持每秒5万亿次的操作。但苹果还没有对这种芯片的架构进行过具体说明。这根本就是苹果演示幻灯片的一个黑匣子。

演示片里面的苹果Neural Engine。

鉴于此,我想知道Giannandrea能不能透露一点Neural Engine在引擎盖之下的工作方式,但他拒绝透露更多细节,而是转移话题。他说app开发者可以通过CoreML(CoreML是一种软件开发API,可为开发人员提供访问iPhone的机器学习功能的权限)收集到自己需要了解的一切信息。

CoreML开发人员API非常清晰地概括了我们所支持的机器学习模型以及运行时模型的种类……我们支持的内核种类也越来越多。而且你可以利用任何流行的机器学习框架(比方说PyTorch或TensorFlow),然后编译出你的模型,再交给CoreML。

CoreML的工作是弄清楚去哪里跑那个模型。也许在ANE上面跑模型是做却做法,也许在GPU上或者在CPU上跑模型是正确做法。而且我们的CPU还针对机器学习进行了优化。

在整个对话过程中,两位高管完全是将第三方开发人员的app与苹果自己的app相提并论的。也就是说,他们的战略不仅仅只是驱动苹果提供的服务和功能;同时也向大型开发者社区至少开放了部分功能。自2008年应用商店推出以来,苹果就一直在依靠开发者来进行进行创新。该公司经常在更新自己的内部开发的app时借鉴那些开发者提出的想法。

当然,内置了机器学习芯片的设备并非只有苹果一家。比方说,三星、华为和高通都在自家的片上系统里面内置了NPU。Google也向开发人员提供了机器学习API。尽管如此,Google的战略和商业模式跟苹果是截然不同的。Android手机在本地无法完成各种各样的机器学习任务。

有一颗苹果芯的Mac

我对Giannandrea和Borchers进行采访的重点并不是他们不久前在WWDC上的那个重大宣布,也就是即将推出带有苹果芯片的Mac。但是当我推测苹果要给Mac设计自己的芯片原因之一可能是要引入Neural Engine时,Borchers说:

我们会第一次拥有一个通用平台,一个可以支持我们以及我们开发人员想要做的事情的硅片平台……。这种能力会解锁一些我们能想到的有趣事物,但更重要的是,它会给其他开发人员带来很多乐趣。

从技术上讲,第一台拥有苹果芯片的Mac机是:Developer Transition Kit。

为了说明苹果的机器学习工具和硬件在Mac上面是怎么用的,Giannandrea举了一个具体的例子:

然后,你可能会说:“呃,看起来挺有趣。可为什么说这种做法很有用呢?” 不妨想象有个视频编辑器,里面是有一个搜索框的,然后你会说:“给我找出桌上的比萨饼。” 然后它就会跳到相应的帧…...大家会想到要有这样的体验。我们非常希望开发人员能够使用这些框架,然后想出让我们感到惊喜的用法。

苹果在自己的开发者大会上表示,计划从今年晚些时候开始发售带自家芯片的Mac。

隐私怎么办呢?

在过去几年的时间里,隐私一直是苹果面向用户的推销语言的核心。它在主旨演讲和市场营销资料里面一再提到这个,同时通过iOS提醒大家去使用相关功能,在接受采访时也经常说这个(本次也是这种情况)。

Giannandrea说:“大家之所以担心AI,显然是因为不知道这玩意儿是什么。他们认为它比看起来更强大,或者他们会用那种科幻的视角看待AI,而且像比尔·盖茨和埃隆·马斯克这样有影响力的人都认为AI是一种危险的技术。”

他认为,其他的大型科技公司对AI的炒作是消极的,而不是积极的,因为那些公司的营销导致“大家担心这项技术”。

机器学习实际上并没有让机器变得像人类一样智能。由于这样或者那样的原因,许多AI专家(包括Giannandrea在内)提出了类似“机器智能”之类的替代性术语,用来表明那种智能跟人类的智能并没有什么相似之处。

不管采用哪种命名方式,机器学习都可能带来非常现实的危险:对用户隐私的破坏。一些公司会以机器学习和训练为名义,不断地从用户那里收集个人数据并将其上传到数据中心。

就像前面所指出那样,此类收集和处理苹果是大量在用户设备本地进行的。Giannandrea明确表示,该决定是跟隐私权问题关联在一起的。他说:“我认为我们对此持非常明确的立场,那就是我们会在尽可能的情况下在你的设备上部署这种先进的机器学习技术,数据不会离开你的设备。对于为什么我们认为我们的设备更安全或更好或者更值得信赖,我们有一个非常明确的声明。”

当然,在很多情况下,你得利用部分用户数据进行机器学习。那么,苹果究竟是怎么利用那些进行处理的用户数据呢?Giannandrea解释说:

一般而言,我们会有两种建模的方式。一种是在哪里收集数据并打标签就在哪里建模,很多时候都是这种情况。在某些情况下,我们会让用户捐献自己的数据。最著名的例子就是Siri,当你安装iPhone的时候,我们会问:“你能不能帮助我们改善Siri?”

在这种情况下,用户会将一定数量的数据捐赠给我们,然后其中很小一部分会用来进行训练。但是,我们这里讨论的很多很多东西(比方说手写),我们是可以收集到足够的数据来对模型进行训练的,那样的模型基本上只需要利用每个人的手写数据即可,根本不需要利用任何其他消费者的数据。

最近已添加了一些要求使用你的数据的提示。去年夏天,一份报告表明Siri被意外激活后正在记录用户的讲话;而负责Siri功能质保的承包商也会收听一些录音。

作为回应,苹果承诺,在用户明确选择共享录音选项(在iOS 13.2推出)来帮助改进Siri之后,自己只会存储与Siri相关的音频,然后会在内部完成所有的质保工作。我问苹果在数据处理方面做法与承包商相比有何不同。Giannandrea回答说:

我们有很多保障措施。比方说,我们有一套流程来识别音频是否给语音助理使用的,而这个流程跟审核音频的流程是完全分开的。所以说,我们在内部做了很多事情来确保我们没有捕捉然后丢弃任何不应该记录的音频。

但是,如果你不愿意做质保(功能改进)的话,那个你永远也没法得到改善。正如你所知道的,机器学习得由你不断去加以改进。为此,在把质保工作放回内部做之后,我们还对工作流和流程进行了全面改革。我们有着改进助理的最好流程之一,而且是在保护隐私的前提下,对此我非常有信心。

显然,苹果正在寻求把隐私保护作为自家设备的一项关键功能。对于Giannandrea来说,他是真心相信这一点的。但这也可以帮助苹果发展市场,因为在移动领域,苹果的最大竞争对手在隐私方面的记录要差得多,而且随着用户越来越关注人工智能对隐私的影响,这让苹果有了蚕食对方市场的可能性。

在整个访谈过程中,Giannandrea和Borchers均强调了苹果战略的两个基本点:1)在本地执行机器学习任务的性能更高; 2)对“隐私保护”(Giannandrea反复强调这个)更好。

黑箱的内部

苹果在过去很长一段时间内基本上都是暗地里在进行AI功能的开发工作,不过在最近几年,苹果对机器学习的重视力度已经有了极大的提高。

公司会定期发布消息,还进行学术赞助,奖学金计划,赞助实验室,参加AI / ML会议。苹果最近还重新推出了一个机器学习博客,在其中分享了自己的一些研究成果。而且苹果还掀起了招聘狂潮,不断挖掘机器学习领域的工程师及其他人员,其中就包括两年前挖来的Giannandrea本人。

还记得Giannandrea前面说过的话吗?他说自己很惊讶Pensil为什么没有利用到机器学习。然后他目睹了实现这一目标的团队的组建。随后,他们跟其他团队一起,做出来靠机器学习驱动的手写功能,这构成了iPadOS 14的基石。

Gianandrea说:“我们苹果拥有很多出色的机器学习人才,我们会继续聘用他们。我发现,苹果很容易就能吸引到世界一流的人才,因为有一点已经变得越来越明显,那就是机器侠学习对于我们想要为用户打造的产品体验至关重要。”

稍微停顿一下之后,他又补充说:“我想我面临的一个最大问题是,我们最雄心勃勃的产品里面有很多是我们没法说出去的,所以这稍微会给我们的说服工作制造一些挑战,‘来我们这里工作吧,我们在做着最雄心勃勃的东西,但是我不能告诉你那是什么。’”

如果大型科技公司和风险投资可以相信的话,那么人工智能和机器学习会在未来几年变得更加普遍。不管怎样,Giannandrea和Borchers让我们清楚了一件事:那就是机器学习现在在苹果产品当中扮演着重要角色,而且消费者每天都在使用的很多功能都有它的影子。等到今年秋天Mac也用上Neural Engine之后,机器学习在苹果所扮演的角色也许还会加大份量。

译者:boxi